Máxima verossimilhança

Predefinição:Mais fontes Em estatística, a estimativa por máxima verossimilhança (maximum-likelihood estimation- MLE) é um método para estimar os parâmetros de um modelo estatístico. Assim, a partir de um conjunto de dados e dado um modelo estatístico, a estimativa por máxima verossimilhança estima valores para os diferentes parâmetros do modelo.

Por exemplo, alguém pode estar interessado na altura de girafas fêmeas adultas, mas devido à restrições de custo ou tempo, medir a altura de todas essas girafas de uma população pode ser impossível. Podemos assumir que as alturas são normalmente distribuídas (modelo estatístico), mas desconhecemos a média e variância (parâmetros do modelo) dessa distribuição. Esses parâmetros da distribuição podem então ser estimados por MLE a partir da medição de uma amostra da população. O método busca aqueles valores para os parâmetros de maneira a maximizar a probabilidade dos dados amostrados, dado o modelo assumido (no caso, distribuição normal).

De maneira geral, posto um conjunto de dados e um modelo estatístico, o método de máxima verossimilhança estima os valores dos diferentes parâmetros do modelo estatístico de maneira a maximizar a probabilidade dos dados observados (isto é, busca parâmetros que maximizem a função de verossimilhança). O método de máxima verossimilhança apresenta-se como um método geral para estimação de parâmetros, principalmente no caso de distribuições normais.

História

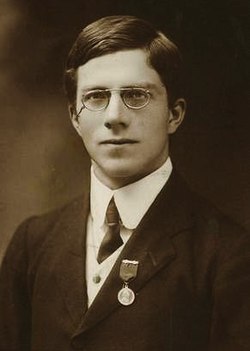

Foi recomendado, analisado e popularizado por R. A. Fisher entre 1912 e 1922, ainda que tenha sido utilizado antes por Carl Friedrich Gauss, Pierre-Simon Laplace, Thorvald N. Thiele e Francis Edgeworth.[1] A determinação de regiões de confiança em torno de estimativas dos parâmetros só foi possível a partir da publicação, em 1938, do Teorema de Wilk's.[2]

Fundamentos

Suponha-se que se tenha uma amostra x1, x2, …, xn de n observações independentes e identicamente distribuídas extraídas de uma função de distribuição desconhecida com função densidade (ou função probabilidade) f0(·). Se sabe, porém, que f0 pertence a uma família de distribuições Predefinição:Nowrap}, chamada modelo paramétrico, de maneira que f0 corresponde a Predefinição:Nowrap, que é o verdadeiro valor do parâmetro. Se deseja encontrar o valor (ou estimador) que esteja o mais próximo possível ao verdadeiro valor θ0.

Tanto xi como θ podem ser vetores.

A ideia desse método é encontrar primeiro a função densidade de todas as observações, que sob condições de independência, é

Observando esta função sob um ângulo ligeiramente distinto, pode-se supor que os valores observados x1, x2, …, xn são fixos enquanto que θ pode variar livremente. Esta é a função de verossimilhança:

Na prática, é geralmente usado o logaritmo dessa função:

O método da máxima verossimilhança estima θ0 buscando o valor de θ que maximiza . Este é o chamado estimador de máxima verossimilhança (MLE) de θ0:

Às vezes, esse estimador é uma função explícita dos dados observados x1, …, xn, mas muitas vezes se precisa recorrer à otimizações numéricas. Também pode acontecer que o máximo não seja único ou não exista.

Na exposição anterior, a independência das observações foi assumida, mas não é um requisito necessário: é suficiente para poder construir a função de probabilidade conjunta dos dados para poder aplicar o método. Um contexto em que isso é comum é a análise de séries temporais.

Propriedades do estimador de máxima verossimilhança

Em muitos casos, o estimador obtido por máxima verossimilhança possui um conjunto de propriedades assintóticas atrativas:

- consistência,

- normalidade assintótica,

- eficiência,

- e inclusive eficiência de segunda ordem depois de corrigir o viés.

Consistência

Sob certas condições bastante habituais,[3] o estimador de máxima verossimilhança é consistente: se o número de observações n tende ao infinito, o estimador converge em probabilidade a seu valor verdadeiro:

Sob condições um pouco mais fortes,[3] a convergência é quase certa:

Normalidade assintótica 2

Se as condições de consistência forem atendidas e também,

- ;

- e é duas vezes continuamente diferenciável em relação a θ em algum entorno N de θ0;

- ∫ supθ∈N||∇θf(x|θ)||dx < ∞, y ∫ supθ∈N||∇θθf(x|θ)||dx < ∞;

- I = E[∇θlnf(x|θ0) ∇θlnf(x|θ0)′] existe e não é singular;

- ,

então o estimador de probabilidade máxima tem uma distribuição assintótica normal:[4]

Invariância funcional

Se é o EMV de θ e g(θ) é uma transformação de θ, então o EMV de α = g(θ) é

Além disso, o EMV é invariável contra certas transformações de dados. De fato se e uma aplicação bijetiva que não depende dos parâmetros estimados, a função densidade de Y é

Ou seja, as funções de densidade de X e Y diferem apenas em um termo que não depende dos parâmetros. Então, por exemplo, o EMV para os parâmetros de uma distribuição log-normal são os mesmos que os de uma distribuição normal ajustada sobre o logaritmo dos dados de entrada.

Outras propriedades

O EMV é √n-consistente e assintoticamente eficiente. Em particular, isto significa que o viés é zero até a ordem n−1/2. Entretanto, ao obter os termos de ordem mais alta da expansão de Edgeworth da distribuição do estimador, θemv tem um viés de ordem −1. Este viés é igual a[5]

fórmula onde se tem adotado a convenção de Einstein para expressar somas; I jk representa l j,k-ésima componente da inversa da matriz de informação de Fisher e

Graças a essas fórmulas, é possível estimar o viés de segunda ordem do estimador e corrigi-lo por subtração:

Este estimador, sem viés até a ordem n−1, se chama estimador de máxima verossimilhança com correção do viés.

Exemplos

Distribuição uniforme discreta

Suponha que n bolas numeradas de 1 a n sejam colocadas em uma urna e que uma delas seja sorteada aleatoriamente. Se n for desconhecido, seu EMV é o número m que aparece na bola extraída: a função de verossimilhança é 0 para n < m e 1/n para n ≥ m; que alcança seu máximo quando n = m. O valor esperado de , é (n + 1)/2. Como consequência, o EMV de n subestimará o verdadeiro valor de n por (n − 1)/2.

Distribuição discreta com parâmetros discretos

Suponha-se que uma moeda inclinada seja jogada no ar 80 vezes. A amostra resultante pode ser algo assim como x1 = H, x2 = T, ..., x80 = T, e se conta o número de caras, "H". A probabilidade que se obtenha cara é p e a de que se obtenha coroa, 1 − p (de modo que p é o parâmetro θ). Suponha-se que se obtenha 49 caras e 31 coroas. Imagine-e que a moeda foi extraída de uma caixa contendo três delas e que estas tem probabilidades p iguais a 1/3, 1/2 e 2/3 ainda que não se saiba qual delas é qual.

A partir dos dados obtidos do experimento se pode saber qual é a moeda com a máxima verossimilhança. Usando a função de probabilidade da distribuição binomial com uma amostra de tamanho 80, número de êxitos igual a 49 e distintos valores de p, a função de verossimilhança toma os seguintes três valores:

A verossimilhança é máxima quando p = 2/3 e este é, portanto, o EMV de p.

Distribuição discreta com parâmetros contínuos

Agora, suponha que houvesse apenas uma moeda, mas sua p poderia ter sido qualquer valor 0 ≤ p ≤ 1. A função de probabilidade a ser maximizada é

e a maximização está acima de todos os valores possíveis 0 ≤ p ≤ 1.

Uma maneira de maximizar essa função é por diferenciação com relação a p e definindo para zero:

a qual tem soluções p = 0, p = 1, e p = 49/80. A solução que maximiza a probabilidade é claramente p = 49/80 (desde que p = 0 e p = 1 resulta em uma probabilidade zero). Então o estimador de probabilidade máxima para p é 49/80.

Esse resultado é facilmente generalizado substituindo uma letra como t no lugar de 49 para representar o número observado de 'sucessos' de nossos ensaios de Bernoulli, e uma letra tal como n no lugar de 80 para representar o número de ensaios de Bernoulli. Exatamente o mesmo cálculo produz o estimador de probabilidade máxima t / n para qualquer sequência de n ensaios de Bernoulli resultando em t 'sucessos'.

Distribuição contínua com parâmetros contínuos

Para a distribuição normal a qual tem função densidade de probabilidade

a função densidade de probabilidade correspondente para uma amostra de n variáveis aleatórias variáveis aleatórias independentes e identicamente distribuídas normais (a probabilidade) é

ou mais convenientemente:

onde é a média amostral.

Esta família de distribuições possui dois parâmetros: θ = (μ, σ), então maximizamos a verossimilhança, , sobre os dois parâmetros simultaneamente ou, se possível, individualmente.

Dado que logaritmo é uma função contínua estritamente crescente sobre o contradomínio da verossimilhança, os valores que maximizam a verossimilhança também maximizarão seu logaritmo. Como maximizar o logaritmo geralmente requer álgebra mais simples, é o logaritmo que é maximizado abaixo. (Nota: a verossimilhança de log está intimamente relacionada a entropia da informação e informação de Fisher.)

que é resolvido por

Este é realmente o máximo da função, pois é o único ponto de virada em μ e a segunda derivada é estritamente menor que zero. Seu valor esperado é igual ao parâmetro μ da distribuição dada,

o que significa que o estimador de verossimilhança máxima é imparcial.

Similarmente diferenciamos a verossimilhança de log em relação a σ e equivale a zero:

que é resolvido por

Inserindo obtem-se

Para calcular seu valor esperado, é conveniente reescrever a expressão em termos de variáveis aleatórias com média zero (erro estatístico) . Expressar a estimativa nessas variáveis resulta

Simplificando a expressão acima, utilizando os fatos que e , nos permite obter

Isso significa que o estimador é tendencioso. Contudo, é consistente.

Formalmente dizemos que o estimador de máxima verossimilhança (EMV) para é:

Neste caso os EMVs pode ser obtido individualmente. Em geral, esse pode não ser o caso, e o EMVs teria que ser obtido simultaneamente.

Variáveis não independentes

Pode ser que as variáveis estejam correlacionadas, ou seja, não sejam independentes. Duas variáveis aleatórias X e Y são independentes apenas se a função de densidade de probabilidade conjunta for o produto das funções individuais de densidade de probabilidade, i.e.

Suponha que se construa um vetor Gaussiano de ordem n fora de variáveis aleatórias , onde cada variável tem médias dadas por . Além disso, faz-se a matriz de covariância ser indicada por

A função densidade de probabilidade conjunta dessas n variáveis randômicas é então dada por:

Nos dois casos variáveis, a função densidade de probabilidade conjunta é dada por:

Neste e em outros casos em que existe uma função de densidade articular, a função de probabilidade é definida como acima, em Fundamentos, usando essa densidade.

Predefinição:Econometria Predefinição:Estatística

- ↑ Edgeworth (Set 1908, Dez 1908)

- ↑ Predefinição:Citar periódico

- ↑ 3,0 3,1 Predefinição:Harvtxt

- ↑ Predefinição:Harvtxt

- ↑ Predefinição:Harvtxt